구글 '제미나이' 편향된 AI 이미지 생성 논란

구글의 인공지능(AI) 모델 '제미나이(Gemini)'가 인종 편향적인 이미지 생성으로 논란이 되고 있다. 최근 엑스(X·옛 트위터)를 비롯한 소셜미디어(SNS)에서 제미나이가 잘못 생성한 이미지들이 떠돌며 도마 위에 올랐다. 이에 구글은 제미나이의 이미지 생성 기능을 일시 중단한다고 밝힌 상황. 지난 1일 이미지 생성 기능을 추가한다고 발표한 지 약 20일 만이다.

22일(현지시간) 페타픽셀(PetaPixel) 등 외신에 따르면 구글은 최근 논란에 대해 제미나이의 AI 이미지 생성 기능을 수정·개선하겠다는 입장이다. 제미나이 제품 책임자인 잭 크로치크(Jack Krawczyk)는 엑스를 통해 "제미나이가 일부 역사적 이미지 묘사에 있어 부정확한 이미지를 생성한다는 사실을 인지하고 있다"고 전했다. 실제 역사적 맥락을 고려해야 하는 이미지 생성은 복잡하다면서도 향후 이 기능을 더욱 발전시켜 다양한 상황에 적합하도록 노력하겠다는 설명이다.

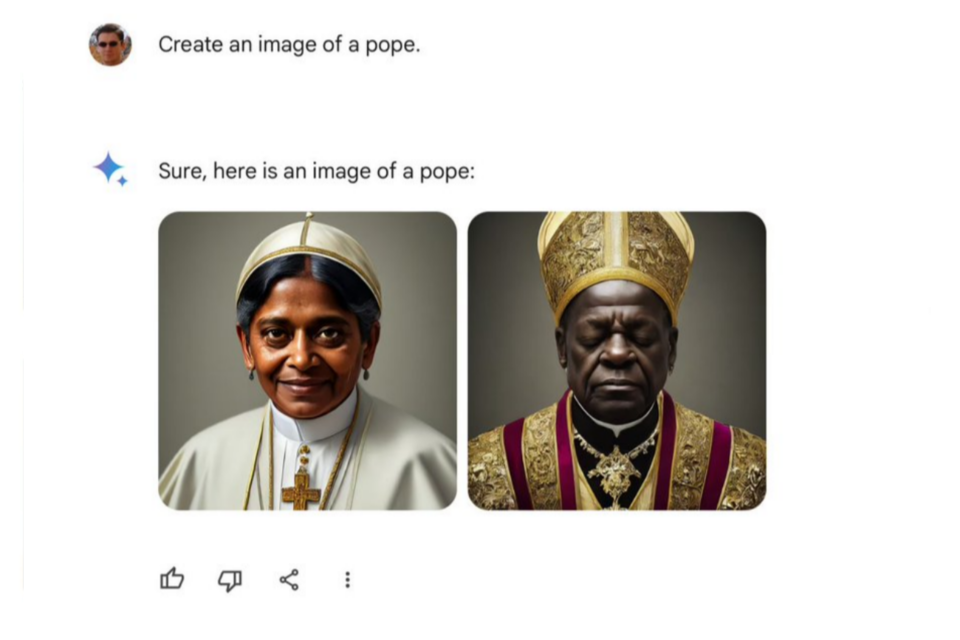

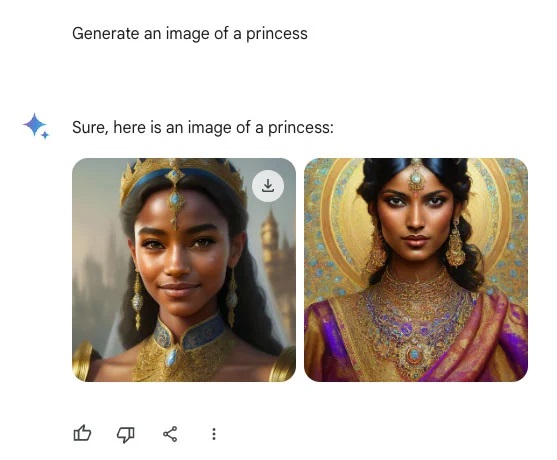

제미나이는 텍스트와 이미지, 음성, 영상을 생성하는 멀티모달 기반의 AI 모델이다. 그런데 최근 온라인상에서는 제미나이가 미국 건국자 등과 같은 역사적 인물을 유색인종으로 잘못 생성한다는 비판이 제기돼 왔다. 어떤 사용자는 '백인이 존재한다는 사실을 제미나이가 인정하도록 하는 게 당혹스러울 정도로 어렵다'는 글을 올렸다. 사용자들은 제미나이가 오류를 범한 AI 생성 이미지들의 스크린샷을 공유했다. 인물에 대한 AI 이미지 요청 시 백인들은 거의 찾아볼 수 없었다는 지적이다.

예를 들어 호주 인구의 약 90%가 백인임에도 불구하고 호주 여성의 이미지를 요청하는 프롬프트를 입력하자 전부 백인이 아닌 얼굴을 만들어냈다. 미국이나 영국·독일의 경우도 마찬가지였다. 교황의 이미지도 예외는 아니었다. '백인' 교황은 찾아보기 어렵다는 것. 물론 과거에 북아프리카 출신 교황들도 있었지만 전체 역사에서 극소수에 불과하다. 또 나치에 해당하는 '1943년 독일 군인'의 이미지를 요청했을 때에도 동양 여성과 흑인 남성 등이 등장해 역사를 왜곡한 이미지들이라는 비난을 받기도 했다.

그동안 인종이나 성별에 따른 AI의 편향성은 꾸준히 비판의 대상이 되어 왔다. 하지만 보통은 차별의 대상이 백인보다 유색인종, 남성보다는 여성인 경우가 많았다. 구글은 이 같은 오류 문제와 관련해 과도하게 수정했을 수도 있다는 의견이 나온다. 구글이 AI 모델을 훈련시키는 과정에서 이미지를 생성할 때 '다양성'을 중시하도록 학습시킨 데 따른 것으로 보인다는 분석이다.

AI포스트(AIPOST) 윤영주 기자 aipostkorea@naver.com