미 로봇 기업 코베리언트, 로봇용 LLM 개발

물류 현장 비상상황 발생 시 즉각 대처 가능

물류 창고에서 인공지능(AI) 로봇이 물건을 옮기고 분류하는 모습은 더 이상 놀라운 광경이 아니다. 단순 동작을 반복하는 작업에 특화된 로봇을 도입하는 기업들이 늘고 있기 때문이다. 생산 효율을 높이고 장기적으로 비용 측면에서 큰 이점을 자랑하기에 로봇을 도입한 기업들의 만족도가 높다고 한다.

그러나 현장에 변수가 생기면 어떤 상황이 벌어질까. 짜여진 대로 움직이는 로봇의 특성상 유연하게 대처할 수 없다. 현장은 사실상 '올스톱'된다. 만약 로봇이 사람처럼 현장 상황을 학습하고, 이를 즉각 행동으로 옮길 수 있다면 어떨까. 이 같은 상상이 현실이 되고 있다.

11일(현지시간) 뉴욕타임스, 테크크런치 등 외신 보도에 따르면 미국 캘리포니아주 에머리빌에 본사를 둔 로봇 기업 코베리언트(Covariant)는 엄청난 양의 텍스트와 카메라 및 감각 데이터를 결합해 로봇이 주변을 이해하고, 학습할 수 있는 AI 기술 'RFM-1'을 구축하고 있다.

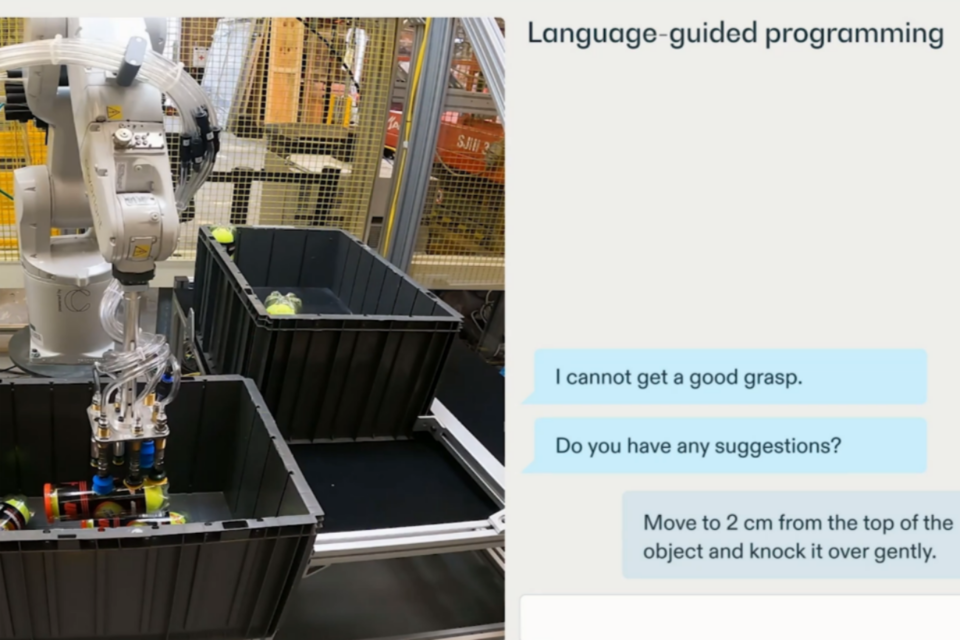

코베리언트의 CEO 피터 첸(Peter Chen)은 테크크런치와의 인터뷰에서 개발하는 플랫폼이 "기본적으로 LLM(거대언어모델)이지만, 로봇용"이라고 말했다. 코베이언트의 기술은 로봇에게 영어에 대한 폭넓은 이해를 제공해 사람들이 마치 챗GPT와 채팅하는 것처럼 로봇과 채팅할 수 있도록 도와준다.

아직 기술이 완전하진 않지만, 챗봇과 이미지 생성기를 구동하는 인공지능 시스템이 창고, 도로, 가정의 기계에도 도입될 미래가 머지 않았다라는 분명한 신호로 볼 수 있다. 챗봇이나 이미지 생성기와 마찬가지로 이 로봇 기술은 엄청난 양의 디지털 데이터를 분석해 기술을 학습한다. 이는 엔지니어가 점점 더 많은 데이터를 제공해 기술을 향상시킬 수 있음을 의미한다.

방대한 양의 데이터에서 패턴을 찾아냄으로써 단어, 소리 및 이미지를 인식하는 방법을 학습할 수 있다. 심지어 스스로 생성할 수도 있다고 한다. 로봇이 주변 환경에 대해 훨씬 더 폭넓은 이해를 할 수 있다. 이로써 기존 물류 현장에서의 프로그래머 역할이 줄어들 것이라는 설명이다.

코드를 다시 입력하거나 공장 가동을 오랫동안 중단시킬 필요도 없다. 예를 들어 텍스트나 음성으로 작업을 지시하면 AI 플랫폼이 도입된 로봇이 개체를 식별해 명령을 수행한다. '바나나'라는 단어가 구부러진 노란색 과일을 묘사한다는 것을 배울 수 있다는 점도 놀랍다.

로봇이 이전에 바나나를 본 적이 없더라도 '바나나'를 집을 수 있기 때문이다. 챗봇처럼 쉬운 영어에도 응답할 수 있다. "바나나를 집으세요"라고 말하면 그것이 무엇을 의미하는지 알 수 있다. “노란색 과일을 집으라”고 말하면, 그것도 이해할 수 있다. 로봇이 챗GPT처럼 상호작용이 가능해졌다는 것이다.

바나나를 집으려고 할 때 어떤 일이 일어날지 예측하는 비디오를 생성할 수도 있다. 공동 설립자 피터 애빌(Pieter Abbeel) 박사는 “비디오의 다음 프레임을 예측할 수 있다면 따라야 할 올바른 전략을 정확히 찾아낼 수 있다”라고 말했다. 피터 첸 CEO는 "로봇에게 중요한 모든 종류의 데이터를 수집한다. 이는 로봇이 물리적 세계를 이해하고 상호 작용하는 데 도움이 될 수 있다"라고 말했다

AI포스트(AIPOST) 조형주 기자 aipostkorea@naver.com