셀카 찍기·공 던지기·기타 연주·귀신 흉내까지

카메라로 인간을 보고 반응 관찰해 행동 개선

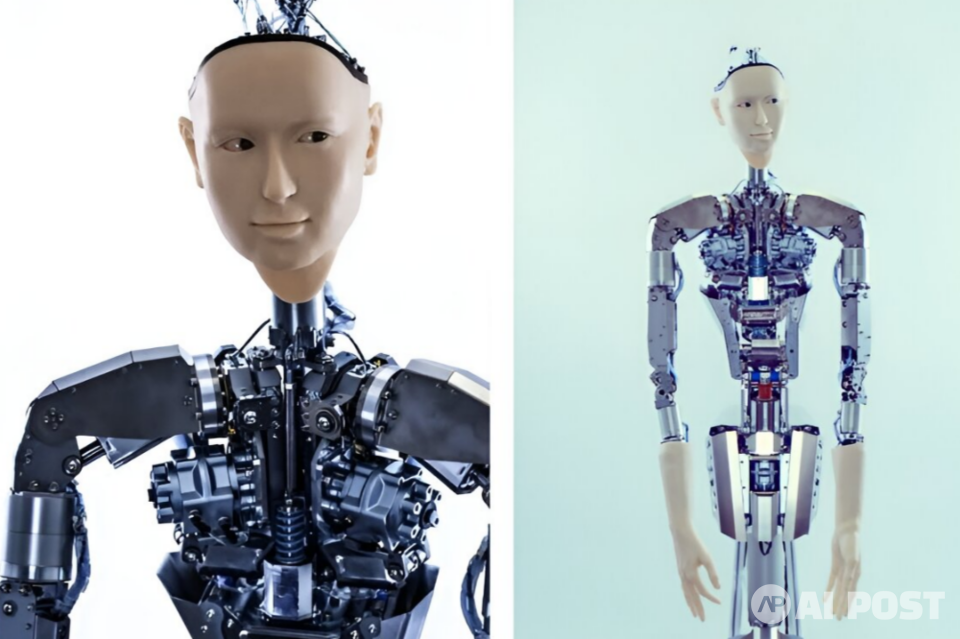

사람의 얼굴을 한 휴머노이드 로봇이 손을 들어 팔꿈치를 구부리고 셀카 찍는 포즈를 취한다. 또 메탈 음악에 맞춰 기타 치는 흉내를 내며 고개를 흔들기도 하고 손가락을 바쁘게 움직인다. 팝콘을 먹는 척 하다가 옆에 앉은 사람의 팝콘 봉지라는 사실을 깨닫고 놀라 당혹스러운 표정도 짓는다. 뼈대만 앙상한 은색 몸체를 보면 누가 봐도 로봇이다. 표정이나 몸짓도 아직 딱딱하고 부자연스러운 구석이 있다. 하지만 하는 행동은 제법 사람과 닮아 있다.

지난 19일(현지시간) 기술 전문매체 테크엑스플로어(TechXplore)는 일본 도쿄대학교 연구팀이 최근 선보인 AI 휴머노이드 로봇 '알터3(Alter3)'를 소개했다. 알터3는 2016년 첫선을 보인 이후 가장 최신 버전이다. 연구팀은 기존 하드웨어에 의존한 제어·조종 장치 없이 로봇에 대형언어모델(LLM)을 탑재해 과거 로봇들보다 좀 더 인간다운 행동을 하도록 만들었다고 한다.

현재 도쿄대 연구팀은 오픈AI의 언어모델인 GPT-4를 사용해 다양한 시뮬레이션에서 로봇을 훈련시키고 있다. 로봇은 셀카 찍기를 비롯해 공 던지기, 팝콘 먹기, 기타 치기 등을 배우는 중이다. 이전에는 이러한 작업을 수행하려면 각 활동에 대한 특정 코딩이 필요했다. 하지만 GPT-4를 적용하면 자연어 교육을 통해 로봇은 광범위한 새로운 기능을 배울 수 있다.

알터3는 인간의 근골격 움직임을 모방한 43개의 축(axes)을 가지고 있다. 다리가 없어 걸을 수는 없지만 섬세한 얼굴 표정과 복잡한 상체 움직임이 가능하다. 또 알터3는 카메라가 장착돼 인간을 볼 수 있다. 연구팀은 알터3가 마치 어린아이처럼 인간의 반응을 관찰함으로써 행동을 개선할 수 있다고 전했다.

LLM 덕분에 로봇에게 원하는 동작을 설명하는 언어 지시를 간단히 내리면 된다. 연구팀은 LLM에 안드로이드 엔진을 실행하는 파이썬(Python) 코드를 생성하도록 지시하는 프롬프트를 전달한다. 알터3는 메모리에 활동 기록을 남겨 연구팀이 로봇의 동작을 다듬고 조정할 수 있다. 시간이 지남에 따라 로봇은 더 빠르고 더 매끄럽고 더 정확한 움직임을 구현할 수 있다는 것.

연구팀은 AI로 구동되는 로봇들이 LLM을 활용해 이해하고 사람 같은 반응을 흉내내면서 인간과 로봇 간의 기본적인 의사소통을 용이하게 하는 데 주로 초점이 맞춰졌다고 말했다. 이제는 프로그램 코드를 통해 인간 행동의 언어적 표현을 로봇의 몸에 매핑(mapping)함으로써 직접적인 제어가 가능하다는 설명이다.

연구팀은 로봇 연구에 LLM을 활용함으로써 인간과 로봇 간 협업의 경계를 재정의할 뿐만 아니라 더 지능적이고 적응력이 뛰어난 로봇 개발의 가능성을 열어준다고 강조했다.

AI포스트(AIPOST) 윤영주 기자 aipostkorea@naver.com