MIT 연구진이 로봇의 두뇌 수준을 끌어올리는 새로운 훈련 모델을 개발했다. GPT-4와 같은 거대언어모델(LLM)에서 영감을 얻었다는 게 연구진의 설명이다.

MIT 연구진은 최근 새로운 로봇 훈련용 모델인 '이질적 사전훈련 트랜스포머(HPT, Heterogeneous Pretrained Transformers)'에 대한 논문을 아카이브에 게재했다.

그간 로봇을 훈련하기 위해서는 구체적인 데이터를 수집해 통제된 환경 속에서 학습을 진행했다. 이러한 방법은 데이터 수집에 드는 비용이 크고, 시간도 오래 걸린다. 이같은 한계를 극복하기 위해 MIT 연구진은 새로운 로봇 훈련용 모델인 HPT를 개발했다.

HPT는 GPT-4와 같은 LLM 훈련 방식에서 영감을 얻어 고안된 모델이다. LLM은 엄청난 양의 언어 데이터로 사전 훈련되고, 이후 미세조정 과정을 거친다. 로봇 훈련 데이터는 이미지, 3차원 깊이 등 다양한 형태가 존재한다. 데이터 수집 환경도 다양하기 때문에 표준화하기 어려운 것이 현실이다.

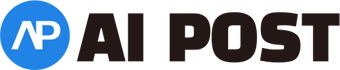

LLM을 훈련하듯이 로봇을 학습시키기 위해서는 새로운 아키텍처가 필요하다고 연구진은 판단했다. MIT 연구원들은 다양한 모드와 도메인의 데이터를 통합하는 아키텍처를 개발했다. 시각과 고유 감각의 데이터를 '토큰'이라고 하는 동일한 유형의 입력으로 정렬하고, 트랜스포머가 이를 처리하도록 했다.

트랜스포머는 모든 입력을 하나의 공유 공간으로 매핑하고, 더 많은 데이터를 처리하고 학습하면서 거대한 사전 학습된 모델로 성장한다. 트랜스포머가 커질수록 성능이 좋아진다는 설명이다. 이를 통해 사용자들은 HPT에 로봇의 설계, 설정 및 수행 작업에 대한 소량의 데이터만 제공하면 된다.

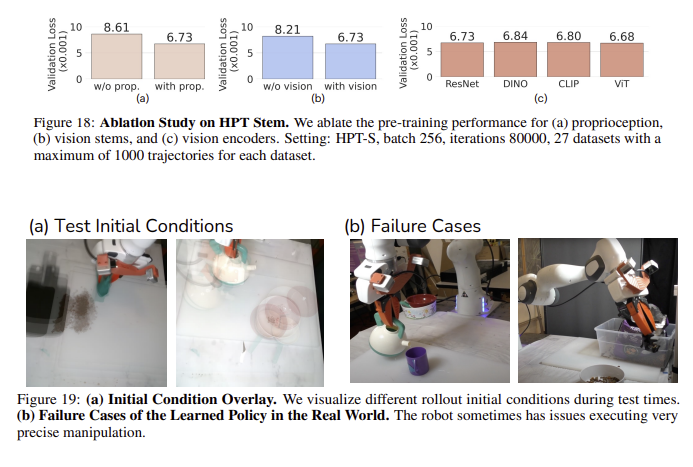

매번 처음부터 훈련하지 않고도 로봇들이 보편적으로 우수한 성능을 보일 수 있게 됐다. 연구진은 HPT 트랜스포머를 사전 훈련시키기 위해 방대한 데이터 셋을 구축했다. 인간 데모 비디오와 시뮬레이션을 포함한 20만개 이상의 로봇 궤적이 포함된 52개 데이터 셋이 포함됐다.

데이비드 헬드 카네기멜론대학교 로봇공학 연구소 교수는 "우리의 꿈은 아무런 훈련 없이도 다운로드해 사용할 수 있는 보편적인 로봇 두뇌를 갖는 것"이라며 "아직 초기 단계지만, 지속해서 LLM처럼 로봇 분야에서도 획기적인 진전이 이뤄지길 바란다"라고 말했다.

AI포스트(AIPOST) 유진 기자 aipostkorea@naver.com