메타 '레이밴' 멀티모달 AI 기능 추가될 것

AI가 보고 들은 정보, 사용자에게 알려준다

사물 식별부터 언어 번역까지 유용성 높여

"헤이, 메타(Hey, Meta)."

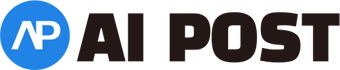

스마트 안경을 쓴 마크 저커버그 메타 최고경영자(CEO)가 인공지능(AI)에게 자신이 들고 있는 셔츠를 보고 이 셔츠에 어울리는 바지들을 추천해달라 요청한다. 그러자 AI는 셔츠의 특징을 설명하면서 이를 보완할 수 있는 바지 몇 가지를 제안한다. 최근 저커버그가 자신의 인스타그램에 공개한 레이밴의 업데이트 시연 영상이다.

메타의 스마트 안경 '레이밴(Ray-Ban)'이 더 똑똑해진다. 레이밴에 탑재된 메타 AI는 사물을 식별하고 언어를 번역한다. 레이밴을 착용한 채 "헤이 메타"라고 부르면 주변에서 무슨 일이 일어나고 있는지 보고 듣는 가상의 AI 비서가 소환된다. 13일(현지시간) 기술 전문매체 엔가젯(Engadget) 등 외신은 레이밴의 새로운 AI 기반 멀티모달(multimodal) 기능을 소개했다.

'멀티모달 AI'는 메타의 AI 어시스턴트(AI assistant)가 레이밴의 카메라와 마이크를 통해 보고 들은 정보에 대해 사용자에게 알려줄 수 있는 기능이다. 외신에 따르면 메타는 사용자의 주변 환경에 따라 질문에 대답할 수 있는 멀티모달 AI 기능을 테스트하기 시작했다.

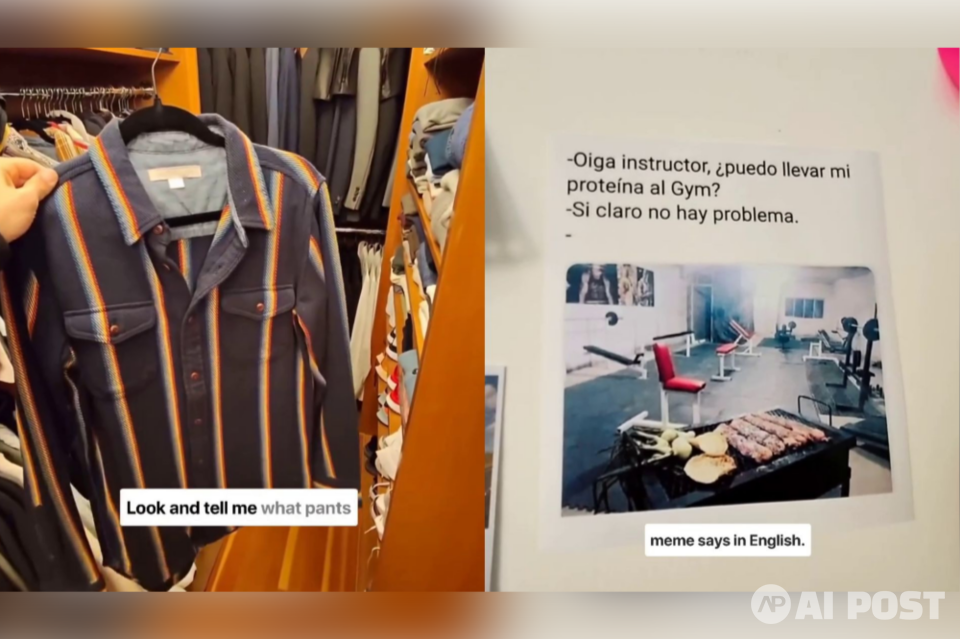

레이밴은 AI 어시스턴트의 개선을 통해 한층 업그레이드될 예정이다. 앤드류 보스워스(Andrew Bosworth) 메타 최고기술책임자(CTO)는 사용자들이 메타 AI에게 자신의 가까운 주변 환경뿐만 아니라 방금 촬영한 사진에 대한 캡션 작성 등 보다 창의적이고 다양한 질문도 할 수 있다고 설명했다.

아울러 메타는 레이밴에 탑재된 AI 어시스턴트에 실시간 정보 지원을 추가하고 있다고 한다. 메타 AI는 실시간 정보를 토대로 질문에 답할 수 있게 된다. 지금까지 메타 AI는 2022년 12월 지식 컷오프(knowledge cutoff) 이후의 새로운 사건이나 교통 상황 등 유용한 정보에 대해서는 답변할 수 없었다. 보스워스CTO는 "이제 미국 내 모든 메타 스마트 안경이 실시간 정보에 접근할 수 있을 것"이라고 말했다.

아쉽게도 레이밴 사용자 대다수가 새로운 멀티모달 AI 기능을 쓰기까지는 좀 더 시간이 걸릴 것으로 보인다. 미리 사용해보는 얼리 액세스(Early Access) 베타 버전은 미국에서 일부 사람들에게만 우선 제공된다. 하지만 아마 내년 중에는 더 많은 사용자가 해당 AI 기능을 누릴 수 있을 것이라는 게 보스워스 CTO의 설명이다.

한편 IT 전문매체 씨넷(CNET)은 실제 레이밴의 새로운 멀티모달 AI 기능의 시연 후기를 전했다. 씨넷은 새로운 기능에 대해 유용성과 가능성 등의 측면에서 대체적으로 긍정적인 평가를 내놨다. 그럼에도 불구하고 베타 버전인 현재로서는 아직 개선할 점이 눈에 띈다는 의견이다. 사용자가 사진을 찍어야만 AI가 사용자가 보고 있는 것을 인식해 분석할 수 있다는 것. 다시 말해 사용자가 음성 요청을 하면 잠시 후 '찰칵' 셔터 소리가 들린다. 그리고 대답이 돌아오기 전 몇 초간 잠시 멈춘다.

음성 프롬프트의 경우도 아쉽다는 이야기가 나온다. 예를 들어 "헤이 메타, 이것 좀 보고 이 재료들로 요리할 레시피를 말해줘." "헤이 메타, 이것 좀 보고 재미있는 캡션을 만들어줘." "헤이 메타, 이것 좀 봐. 무슨 식물이야?" 등등 음성 요청을 하려면 항상 '헤이, 메타'로 시작해야 한다. 게다가 AI가 사진을 찍도록 보라고 한 다음 요청하고 싶은 내용이 무엇이든지 즉시 말해야 한다. 이 밖에 가끔 환각 현상이 나타나기도 했다는 지적이다.

AI포스트(AIPOST) 윤영주 기자 aipostkorea@naver.com