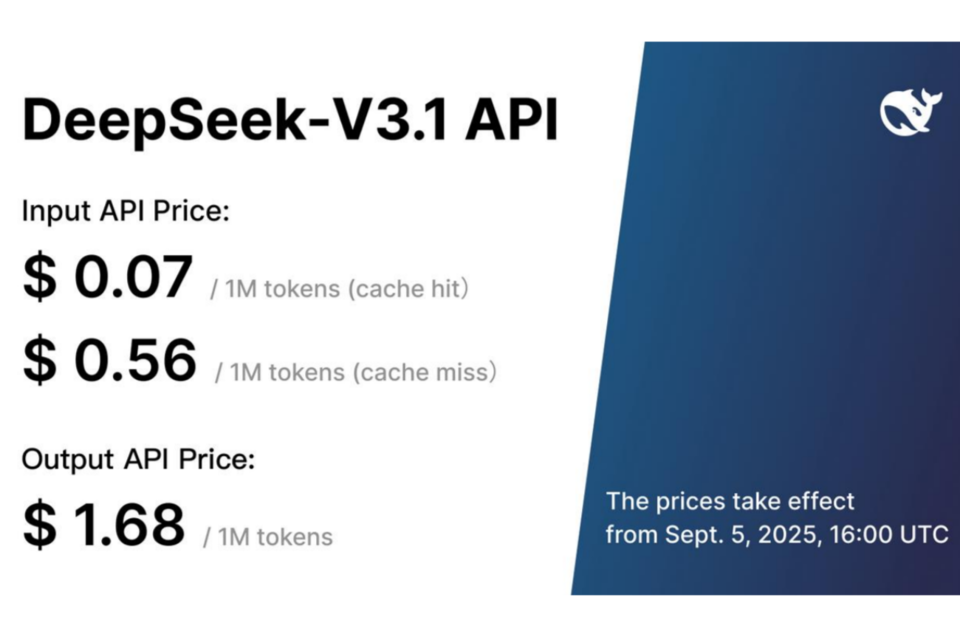

중국 인공지능(AI) 스타트업 딥시크가 자사의 기존 거대언어모델(LLM) V3 모델을 업그레이드한 V3.1 버전을 공개했다.

딥시크는 공식 엑스(X)를 통해 V3.1 버전을 출시했다고 밝혔다. 딥시크는 "V3.1은 추론·비추론 과제를 모두 사용할 수 있는 하이브리드 모델"이라고 소개했다. 이번 모델은 콘텍스트 윈도를 12만 8000토큰으로 확장돼, 약 300페이지 분량의 정보를 한 번에 처리할 수 있다.

V3.1은 직전 모델과 비교해 코딩 성능이 개선됐다. AI 코딩 성능을 평가하는 에이더 벤치마크(Aider Benchmark)에서 중국 모델 가운데 최고 점수를 기록했다. 글로벌 경쟁사들과 비교하면 V3.1은 클로드 오퍼스4(Claude Opus 4) 등 선두 모델보다 낮은 수준으로 평가됐다.

딥시크의 V3.1 모델은 허깅페이스 플랫폼을 통해 이용할 수 있다. 다만 V3.1의 구체적인 기술 사양은 공개되지 않았다. 한편 딥시크는 올해 초 'R1'을 출시하면서 세계적인 관심을 받았다. 그러나 개인정보 수집 논란에 휩싸이며 국내에선 입지를 다지는 데 어려움을 겪었다.

업계에서는 지속적으로 차기 모델 'R2' 출시를 기대하고 있다는 반응이 나오고 있다. 그러나 최근 딥시크의 'R2' 개발이 난항을 겪고 있다는 소식이 전해졌다. 파이낸셜타임스(FT)는 지난주 딥시크가 화웨이의 어센드(Ascend) 칩으로 R2 모델을 훈련하는 과정에서 기술적 문제를 겪으며 출시를 지연하고 있다고 보도했다.

딥시크 창업자 량원펑은 내부 회의에서 R2 모델 개발이 지연되는 것에 대해 강한 불만을 표하며 고급 모델을 위해 더 많은 시간을 투자해야 한다고 강조한 것으로 전해졌다. 딥시크는 향후 개발 일정이나 로드맵은 공개하지 않았다.

AI포스트(AIPOST) 유형동 수석기자 aipostkorea@naver.com